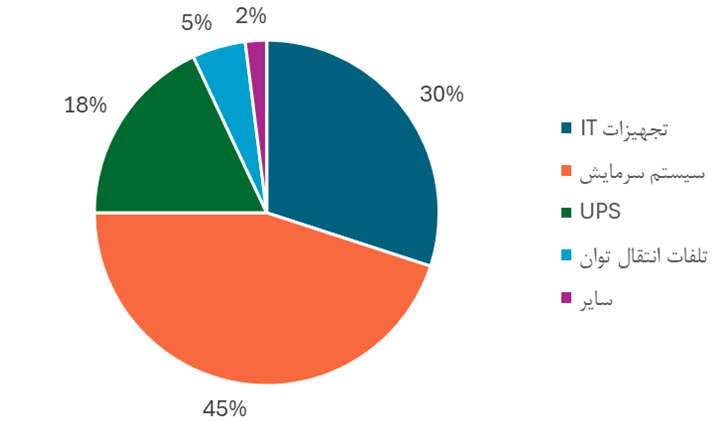

با رشد شتابان فناوریهای مبتنی بر داده و هوش مصنوعی، مراکز داده به یکی از پرمصرفترین زیرساختهای انرژی و آب در جهان تبدیل شدهاند. این گزارش تحلیلی نشان میدهد در یک مرکز داده معمولی تنها ۳۰ درصد انرژی صرف تجهیزات فناوری اطلاعات میشود، در حالی که حدود ۴۵ درصد آن به سیستمهای سرمایش اختصاص دارد. در شرایطی که کشور فاقد استاندارد الزامآور مصرف انرژی برای این ساختمانهاست، استفاده از چارچوبهایی نظیر ASHRAE 90.4 و تدوین استاندارد ملی میتواند گامی ضروری برای مدیریت مصرف در این بخش باشد.

این گزارش تحلیلی با هدف بررسی وضعیت کنونی و ترسیم چشمانداز بهینهسازی مصرف انرژی و آب در مراکز داده، با تمرکز ویژه بر شرایط کشور تهیه شده است. مراکز داده بهعنوان زیرساختهای حیاتی اقتصاد دیجیتال، با رشد سریع فناوریهای مبتنی بر داده و هوش مصنوعی، سهم فزایندهای از مصرف انرژی و آب را به خود اختصاص میدهند. طبق پژوهشهای بینالمللی، در یک مرکز داده معمولی، تنها حدود ۳۰ درصد انرژی صرف تجهیزات فناوری اطلاعات میشود، در حالی که سیستمهای سرمایش با سهمی در حدود ۴۵ درصد، بزرگترین مصرفکننده انرژی بهشمار میروند. ازاینرو، تمرکز بر بهبود طراحی و بهرهبرداری سیستمهای خنککاری، کلید اصلی کاهش مصرف منابع در این مراکز است.

در این گزارش چه میخوانید؟

- چرا تنها ۳۰٪ انرژی مراکز داده صرف پردازش میشود و ۴۵٪ آن به سیستمهای سرمایش اختصاص دارد؟

- میانگین جهانی PUE چرا 1.58 است و چگونه شرکتهایی مانند Google و Microsoft به محدوده 1.1 رسیدهاند؟

- آیا اقلیمهای سرد و خشک ایران میتوانند مزیت رقابتی برای توسعه مراکز داده کممصرف ایجاد کنند؟

- و در غیاب استاندارد ملی، استفاده از چارچوب ASHRAE 90.4 چه خلأیی را پوشش میدهد؟

این گزارش با اتکا به شاخصهای PUE و WUE، مقایسه دادههای جهانی و تحلیل اقلیمی کشور، تصویری روشن از شکاف بهرهوری، مسیرهای فناورانه پیشرو و الزامات سیاستگذاری در توسعه زیرساختهای دیجیتال ایران ارائه میدهد.

در این گزارش، ابتدا مفهوم مرکز داده، انواع آن از منظر مالکیت، بهرهبرداری و سطح دسترسپذیری تشریح شده است. سپس با معرفی شاخصهای کلیدی ارزیابی عملکرد شامل ضریب بهرهوری انرژی (PUE)، ضریب بهرهوری آب (WUE)، شاخص بار مکانیکی (MLC) و شاخص تلفات الکتریکی (ELC)، چهارچوبی برای مقایسه و ارزیابی مراکز داده ارائه شده است. بررسی دادههای جهانی نشان میدهد که اگرچه شرکتهای پیشرو فناوری به مقادیر بسیار پایین PUE و WUE دست یافتهاند، اما میانگین جهانی همچنان فاصله معناداری با این اعداد و مقادیر پیشنهادی سازمان ملل برای مراکز داده جدید و در حال بهرهبرداری دارد.

بخش دیگری از گزارش به مرور روشهای مختلف خنککاری مراکز داده اختصاص یافته است؛ از سامانههای متداول هواپایه تا روشهای پیشرفته مایعپایه شامل صفحه سرد، جریان دوفاز و سرمایش غرقابی. نتایج مطالعات نشان میدهد که با افزایش توان نامی تجهیزات، بهویژه در کاربردهای هوش مصنوعی، استفاده از روشهای سرمایش مایع نهتنها اجتنابناپذیر، بلکه از منظر انرژی و آب نیز مقرونبهصرفهتر است. در عین حال، ترکیب هوشمندانه روشها متناسب با اقلیم، دسترسی به آب و توان و سطح آلودگی هوا، بهترین عملکرد را به همراه خواهد داشت.

در ادامه، وضعیت مراکز داده در ایران بررسی شدهاست. با وجود رشد سریع تعداد این مراکز در کشور، استاندارد الزامآوری برای میزان مصرف انرژی و آب در این نوع ساختمانها وجود ندارد. بر این اساس، پیشنهاد میشود در کوتاهمدت از استاندارد ASHRAE 90.4 بهعنوان مرجع ارزیابی استفاده شود و در میانمدت، تدوین استاندارد ملی الزامآور برای مصرف انرژی و آب مراکز داده در دستور کار قرار گیرد.

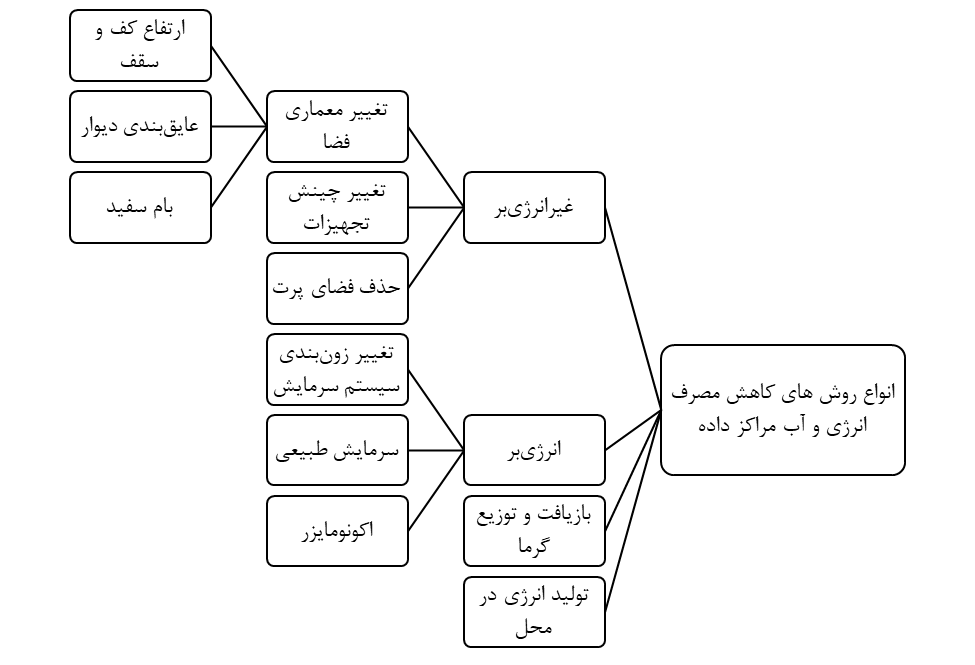

همچنین مجموعهای از راهکارهای عملی برای کاهش مصرف انرژی در مراکز داده فعال در کشور در دو دسته غیرانرژیبر (مانند بهینهسازی معماری فضا، چینش رکها، عایقبندی و حذف فضاهای پرت) و انرژیبر (مانند زونبندی حرارتی، سرمایش طبیعی، استفاده از اکونومایزر، بازیافت گرما و تولید انرژی در محل) پیشنهاد شده است.

در جمعبندی، پیشنهاد میشود با توجه به تنوع اقلیمی کشور، مراکز داده جدید در مناطق سرد و خشک مانند مرکز استان خراسان رضوی، آذربایجان شرقی و اراک جانمایی شود. چنانچه این مراکز جدید در خارج کلانشهرها ساختهشوند، با توجه به کمتر بودن سطح آلودگی هوا در این مناطق، میتوان با استفاده از سرمایش طبیعی، هزینههای خنککاری را کاهش داد.

مرکز داده به چه معناست و چه انواعی دارد؟

مرکز داده[1] به واحدی اطلاق میشود که تجهیزات حساس مرتبط با فناوری اطلاعات[2] مانند انواع سرورها، تجهیزات شبکه و واحدهای ذخیرهسازی اطلاعات را در خود جای میدهد. این مراکز جهت پردازش اطلاعات، میزبانی از نرمافزارهای مختلف و پشتیبانی از خدمات ارتباطی استفاده میشوند[1]. اولین مرکز داده با تعریف جدید آن در سال 2002 و توسط شرکت آمازون جهت تسهیل پردازش ابری راهاندازی شد[2].

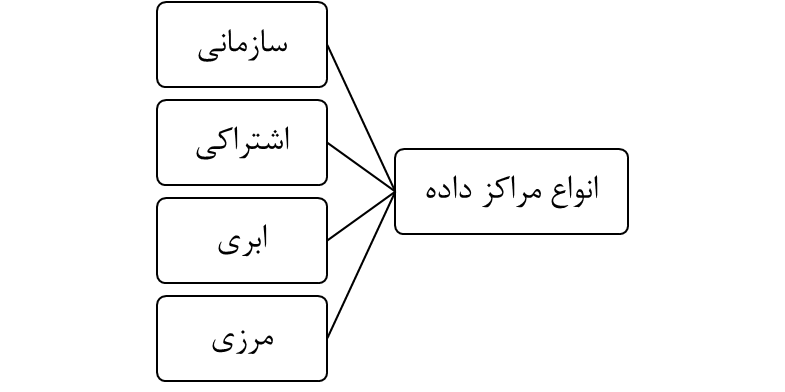

مراکز داده را میتوان بر حسب نوع مالکیت و بهرهبرداری از آنها مطابق شکل 1 تقسیمبندی کرد.

مالکیت و بهرهبرداری از یک مرکز سازمانی توسط یک سازمان خاص انجام شده و مرکز صرفاً برای پشتیبانی از نیازهای زیرساختی داخلی سازمان مورد استفاده قرار میگیرد. این نوع واحدها عموماً با یک هدف کاری مشخص ساخته میشوند و اغلب در نزدیکی محل سازمان جانمایی میشوند.

مرکز داده اشتراکی تأسیساتی است که در آن فضای فیزیکی، توان (برق) و زیرساخت سرمایشی مشترک برای پشتیبانی از تجهیزات فناوری اطلاعات چندین شرکت وجود دارد. در این نوع مرکز، مالک زیرساخت را به بهرهبرداران اجاره میدهد.

مراکز داده ابری به مجموعهای از تأسیسات گفته میشود که توسط شرکتهای ارائهدهنده خدمات ابری اداره میشوند. این مراکز با پشتیبانی از امکان دسترسی برخط، به کسبوکارها اجازه میدهند تا زیرساختهای مورد نیاز خود را متناسب با نیاز سازمان مقیاسپذیر کنند. تفاوت مرکز ابری و اشتراکی در آن است که عموماً دسترسی فیزیکی به تأسیسات اشتراکی برای بهرهبرداران امکانپذیر است حال آن که استفادهکنندگان از تأسیسات ابری صرفاً دسترسی برخط به این نوع از واحدها دارند.

مراکز مرزی به آن دسته از مراکز داده اطلاق میشود که به نسبت سایر گروهها کوچکتر بوده، در نزدیکی کاربران جانمایی میشوند و هدف از آنها کاهش تأخیر دسترسی به دادهها و منابع پردازشی است.

همچنین مراکز داده را میتوان از نظر دسترسپذیری[3] به چهار گروه طبقهبندی کرد. دسته اول (حالت پایه) دارای سیستم UPS، سیستم سرمایش اختصاصی و ژنراتور میباشد. در دسته دوم ظرفیت اضافی[4] برای تجهیزات مذکور در نظر گرفته میشود (تجهیزات با ضریب اطمینان بالاتر طراحی میشوند). ظرفیت تجهیزات در دسته سوم بهگونهای طراحی میشود که امکان اجرای عملیات تعمیر بدون ایجاد اختلال در عملکرد سیستم امکانپذیر باشد. در نهایت و در دسته چهارم، دو یا چند سری از تجهیزات مربوط به توان اضطراری جانمایی میشود تا در صورت هرگونه اختلال در یکی از این سیستمها، عملکرد پردازشی سرورها به هیچ عنوان دچار مشکل نشود[3].

چرا توجه به روش خنککاری مرکز داده حائز اهمیت است؟

در حالی که هدف اصلی یک مرکز داده، پردازش، ذخیرهسازی و پشتیبانی از فرآیندهای مرتبط با فناوری اطلاعات است، تحقیقات علمی نشان دادهاند که تنها 30% از انرژی مصرفی در این واحدها به این اهداف اختصاص دارد. این در حالی است که سیستم سرمایش با مصرف 45% از انرژی، بزرگترین مصرفکننده انرژی در این مراکز به شمار میرود (شکل 2)[4].

به صورت کلی و طبق پیشنهاد اشری[1]، دمای فضای داخلی یک مرکز داده میبایست بین 18 تا 27 درجه سانتیگراد نگهداری شود. همچنین، میزان رطوبت نسبی محیط برای کاهش احتمال تخلیه الکترواستاتیک میبایست بین 8 تا 45 درصد باشد. رطوبت نسبی بالا در حضور برخی آلایندهها مانند اوزون، نیتروژن دیاکسید، گوگرد دیاکسید، کلر و هیدروژن سولفید[2] میتواند منجر به خوردگی مس شود[5].

جهت کاهش ریسک خرابی زودرس تجهیزات، کمیته علمی مربوطه در سازمان اشری پیشنهاد میکند تا فضای داخلی مراکز داده در سطح 8 تمیزی طبق تعریف ایزو 14644 نگهداری شوند. این سطح از تمیزی هوا نیازمند استفاده از فیلترهای MERV 8 به بالاست[6].

کمیتهای مهم برای بررسی عملکرد مراکز داده از نظر مصرف انرژی و آب کدامند؟

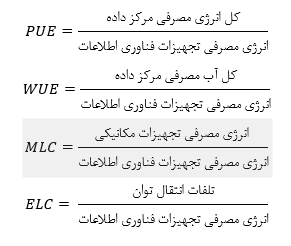

انواعکمیتها با تعاریف مختلف برای بررسی و مقایسه مراکز داده مورد استفاده قرار میگیرند. مهمترین آنها به ترتیب ضریب بهرهوری مصرف انرژی[1] (PUE)، ضریب بهرهوری آب[2] (WUE)، شاخص بار مکانیکی[3] (MLC) و شاخص تلفات الکتریکی[4] (ELC) است. تعریف ضریب بهرهوری انرژی و آب در خانواده استاندارد ایزو 30134 آمده است[7]. تعاریف مربوط به شاخص بار مکانیکی و شاخص تلفات الکتریکی در استاندارد اشری 4/90 آمده است[8]. تعریف هریک از این کمیتها بنا به مراجع ذکر شده به شرح زیر است:

در رابطه با کمیتهای فوق، دقت به موارد زیر الزامی است:

- ضریب بهرهوری انرژی شامل کل انرژی مصرفی واحد مرکز داده است در حالی که شاخص بار مکانیکی صرفاً انرژی مصرفی برای تجهیزات مکانیکی اعم از چیلر، فن، پمپ، هواساز و غیره را شامل میشود. در هنگام طراحی یک مرکز داده جدید، اطلاعات مربوط به توان تجهیزات مکانیکی در دسترس هستند (انتخاب طراح)، درحالی که برای به دست آوردن کل انرژی مصرفی یک واحد مرکز داده در مرحله طراحی میبایست اطلاعات دقیقی از چگونگی عملکرد و جزئیات تکتک تجهیزات موجود در این واحد اطلاع دقیق کسب کرد.

- ضریب بهرهوری انرژی برابر با یک حالت ایدئال است و بدان معناست که تمام انرژی ورودی به یک مرکز داده صرف تجهیزات فناوری اطلاعات شدهاست لذا مقدار این کمیت برای یک مرکز داده همواره بیش از یک است.

- میزان مصرف آب و انرژی علاوه بر نوع طراحی مرکز داده، اتلافهای انتقال توان و سایر کمیتهای درون ساختمان، به شرایط اقلیمی محل مرکز داده نیز وابسته است.

- سه کمیت مرتبط با انرژی یعنی ضریب بهرهوری انرژی، شاخص بار مکانیکی و شاخص تلفات الکتریکی همگی بدون بعد هستند درحالی که ضریب بهرهوری آب در واحد لیتر بر کیلووات-ساعت گزارش میشود.

- مخرج کسر در تعاریف فوق یکسان است و برابر با انرژی مصرفی برای واحدهای فناوری اطلاعات است (بخشی که در شکل 2، 30 درصد را به خود اختصاص داده است).

مقدار میانگین ضریب بهرهوری آب و انرژی در دنیا چقدر است؟

طبق گزارش شرکت گوگل، میانگین ضریب بهرهوری انرژی در میان مراکز داده موجود در دنیا برابر با 58/1 میباشد[9]. این در حالی است که شرکتهای گوگل، آمازون، ماکروسافت و متا ادعا میکنند ضریب بهرهوری انرژی در مراکز داده این شرکتها به ترتیب برابر با 09/1 ، 15/1، 16/1 و 08/1 است [9], [10], [11], [12]. میانگین ضریب بهرهوری آب در دنیا در حال حاضر برابر با 8/1 لیتر به ازای کلووات-ساعت است. اعداد منتشر شده از طرف شرکتهای آمازون، ماکروسافت و متا ضریب بهرهوری آب در مراکز داده مربوط به این شرکتها را به ترتیب برابر با 15/0، 30/0 و 19/0 لیتر به ازای کلووات-ساعت اعلام کردهاند.[10], [11], [12]

دستورالعمل سازمان ملل برای مراکز داده که در تابستان سال 2025 منتشر شدهاست پیشنهاد میکند که مقدار ضریب بهرهوری انرژی (PUE) برای مراکز داده در حال کار 5/1 و برای مراکز جدید 4/1 تعیین شود. همچنین این مرجع مقدار 5/1 لیتر به ازای کیلووات-ساعت را برای ضریب بهرهوری آب (WUE) پیشنهاد میکند[13].

انواع روشهای سرمایش این مراکز چیست؟

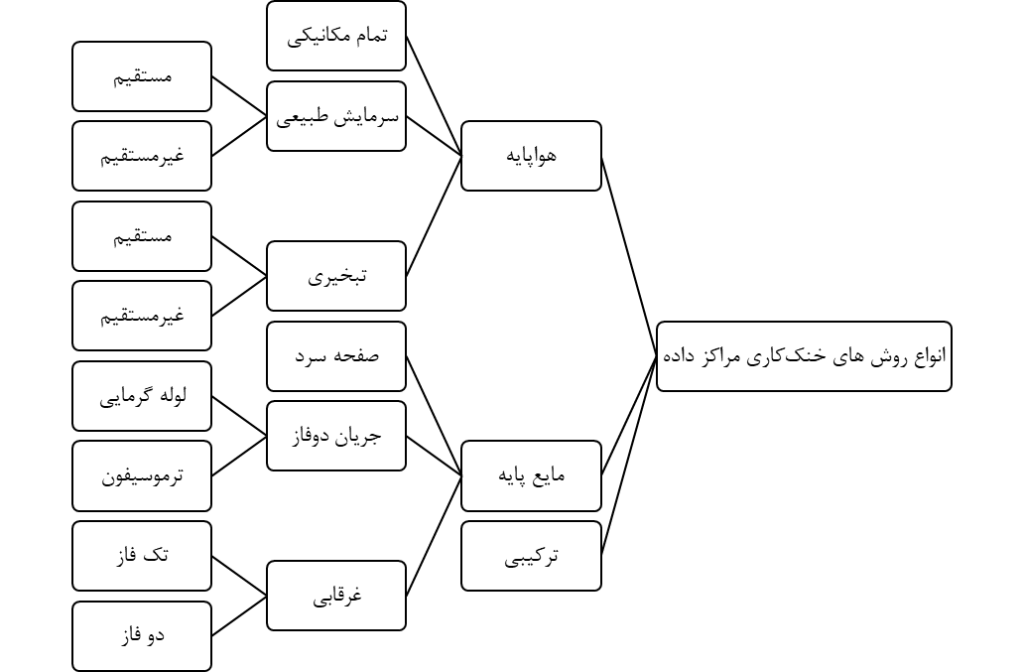

برای خنککاری مراکز داده از روشهای مختلفی میتوان استفاده کرد. تقسیمبندی این روشها به صورت شکل 3 پیشنهاد نگارنده است:

الف. هواپایه:

مقصود از سامانه هواپایه آن است که سیال منتقلکننده حرارت از داخل فضای مرکز داده به بیرون، هوا است. این انتقال میتواند با استفاده از چرخه تبرید مکانیکی[1] و با استفاده از تجهیزاتی مانند چیلر هواخنک یا آبخنک، هواساز، فن و برج خنککننده (در صورتی که از چیلر آبخنک استفاده شود) و یا با استفاده از تجهیزات انبساط مستقیم[2] مانند انواع کولرگازی و یا کولرهای پنجرهای صورت گیرد.

تمام مکانیکی: به استفاده صرف از تجهیزات تبرید تراکمی یا چیلرهای جذبی اطلاق میشود. سرمایش در این روش صرفاً بر عهده این تجهیزات است.

سرمایش طبیعی: به سیستم خنککاری اطلاق میشود که در صورت مطلوب بودن دما و رطوبت هوای خارج از ساختمان، هوای محیط پیرامون ساختمان را به صورت مستقیم و یا غیرمستقیم (از طریق یک مبدل حرارتی واسط) به فضای داخلی مرکز داده تزریق کرده و از این طریق گرمای حاصل از فعالیت تجهیزات فناوری اطلاعات را به خارج ساختمان منتقل میکند. بهکارگیری کامل این نوع سیستم خنککاری (بدون استفاده چرخه تبرید به صورت کمکی) تنها در مناطق جغرافیایی محدودی امکانپذیر است که شرایط دمایی هوای خارج در بیشتر ایام سال برای خنکسازی مناسب باشد.

سیستم سرمایش طبیعی غیرمستقیم با قطع ارتباط هوای بیرون با داخل فضای مرکز داده، به کنترل وضعیت آلایندهها درون فضای مرکز کمک میکند.

تبخیری: دمای هوای بیرون ساختمان با استفاده از گرمای نهان تبخیر کاهش مییابد. سپس، هوای خنک شده برای کاهش دمای مرکز داده مورد استفاده قرار میگیرد. روش مستقیم تبخیری عملکردی مشابه با کولرهای آبی یا ایرواشرها[3] دارد. در روش غیرمستقیم، هوای تزریقشونده به فضای داخلی با رطوبت ناشی از تبخیر آب مستقیماً تبادل حرارت ندارد. روش غیرمستقیم به دلیل عدم افزایش رطوبت نسبی محیط داخلی مناسبتر است.

ب. مایع پایه:

در این دسته روش، سیال اصلی منتقلکننده حرارت، یک سیال در فاز مایع است.

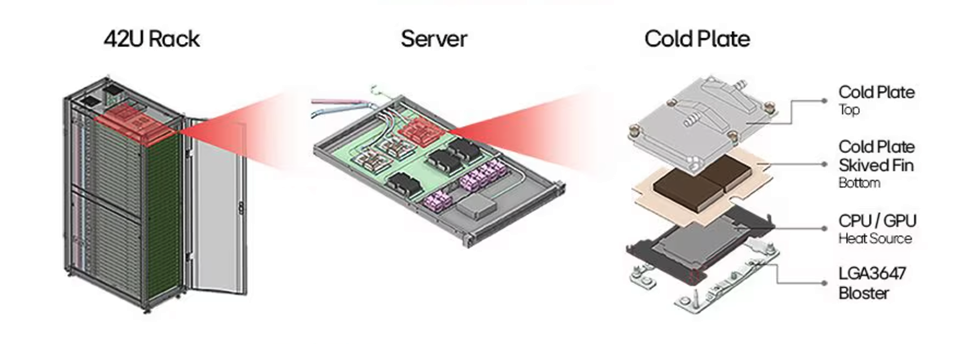

روش صفحه سرد[1]: تجهیزات حرارت را با سیال از طریق مجموعهای از فینها تبادل کرده، حرارت از این طریق به سیال منتقل میشود. گرچه در این سیستمها سیال با تجهیزات تماس مستقیم ندارد اما جهت از بین بردن ریسک اتصالی تجهیزات الکتریکی، در این نوع از خنککاری به جای آب، از مبردهای رایج در سیستمهای سرمایشی استفاده میشود[14] (شکل 4).

جریان دوفاز[1]: امکان تبادل حرارت سیال در دمای ثابت (نقطه تبخیر) با تجهیزات الکتریکی و کاهش تنش حرارتی این تجهیزات از مهمترین مزایای استفاده از این روش در مقایسه با سایر روشها است. روش لوله گرمایی[2] و ترموسیفون[3] هردو بر مبنای تبخیر سیال در ناحیه گرم (سمت پردازنده) و تحویل این گرما به ناحیه سرد (کندانسور یا مبدل واسط) عمل میکنند.

روش غرقابی[4]: به نوعی از سرمایش تجهیزات الکترونیک اطلاق میشود که طی آن، تجهیز کاملاً درون سیال فرو میرود و حرارت تولیدی تجهیزات به صورت مستقیم (بیواسطه – بدون مبدل حرارتی، فین یا صفحه جداکننده) به سیال منتقل شده و سیال با تبخیر خود، این حرارت را به نقطه کندانسور منتقل میکند. چنانچه ذیل این فرآیند، سیال تغییر فاز بدهد (از مایع به گاز و بالعکس)، به آن غرقابی دوفاز و چنانچه سیال صرفاً دچار تغییر دما شود و تبدیل فاز صورت نگیرد، به آن غرقابی تک فاز گفته میشود. تفاوت روش غرقابی با جریان دوفاز در وجود تماس بیواسطه مابین سیال و تجهیزات است. بدیهی است سیال مورد استفاده در روش غرقابی نباید رسانای الکتریکی باشد لذا به جای استفاده از آب یا سایر هادیهای الکتریکی از انواع مبردها و روغنهای حرارتی استفاده میشود.

ترکیبی: در بسیاری از موارد اجراشده در سطح دنیا، ترکیبی از روشهای فوق با توجه به موقعیت جغرافیایی، میزان دسترسی به توان و منابع آبی، میزان آلودگی هوای محیط (برای روشهایی که از هوای پیرامون ساختمان در آن استفاده میشود) و هزینههای مرتبط با آن، استفاده میشود.

دستورالعمل اشری پیشنهاد میکند که چنانچه توان نامی هریک از تجهیزات فناوری اطلاعات مورد استفاده کمتر از 200 وات باشد از روشهای هواپایه و برای تجهیزات با ظرفیت بیش از 400 وات از روشهای سرمایش مایع استفاده شود[5]. طبق گزارش دسامبر 2024 پژوهشگاه برکلی آمریکا[5]، میانگین توان نامی سرورهای معمولی با دوپردازنده در این سال برابر با 600 وات گزارش شدهاست. این در حالی است که توان نامی یک تجهیز با دو پردازنده گرافیکی[6] مورد استفاده برای فعالیتهای مرتبط با هوش مصنوعی برابر با 2000 وات ثبت شدهاست. این اعداد نشان میدهد که جهت حرکت به سمت فناوری هوش مصنوعی و با توجه به میزان توان مورد نیاز این تجهیزات، استفاده از روشهای خنککاری پیشرفته الزامی است[16].

ضریب بهرهوری آب و انرژی برای روشهای مختلف سرمایش چقدر است؟

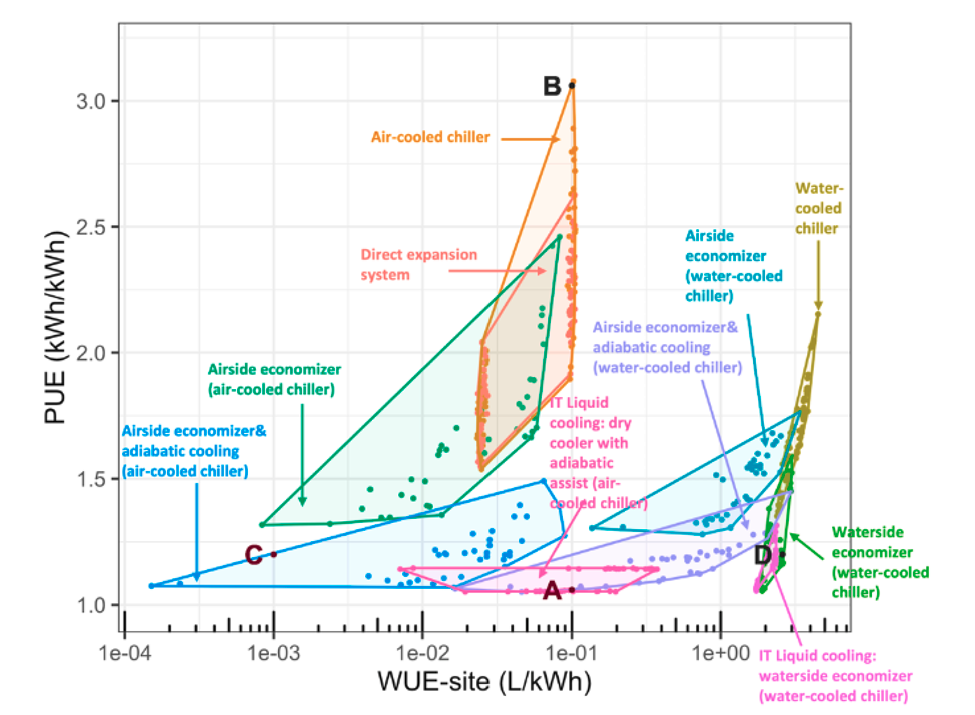

شکل 5 مقدار ضرایب بهرهوری آب و انرژی را برای روشهای مختلف توضیح داده شده نشان میدهد[17]. توجه شود که محور افقی لگاریتمی است. توجه شود که شکل زیر تفاوتهای استفاده از تجهیزات مختلف در شرایط اقلیمی متفاوت را نشان نمیدهد. نکاتی درباره این شکل:

- استفاده از چیلرهای آبخنک ضریب بهرهوری آب را به شدت افزایش میدهد. آببرترین روشها در این شکل (سمت راست) همگی از چیلر آبخنک استفاده میکنند.

- استفاده از چیلر هواخنک و تجهیزات انبساط مستقیم (مانند کولر گازی)، انرژیبرترین روش خنککاری مرکز داده است.

- استفاده از سرمایش طبیعی همراه در کنار چیلر هواخنک (متوازیالاضلاع سبزرنگ)، میزان مصرف انرژی را به شدت کاهش داده و میتواند بر میزان مصرف آب نیز تأثیرگذاری مثبت داشته باشد.

استفاده از روشهای سرمایش پیشرفته چه مزایایی برای بهرهبرداران این مراکز دارد؟

در کنار کاهش مصرف انرژی و آب با بهکارگیری روشهای پیشرفتهی خنککاری، این فناوریها آثار جانبی مثبتی نیز بر عملکرد و دوام تجهیزات الکترونیکی دارند. به عنوان نمونه، یکنواختی دما در مرکز داده سبب میشود تجهیزات فناوری اطلاعات تنش حرارتی کمتری را تجربه کرده و در نتیجه طول عمر مفید آنها افزایش یابد. از سوی دیگر، خروج دما و رطوبت نسبی محیط از محدودههای تعیینشده در استانداردها میتواند احتمال بروز تخلیه الکترواستاتیکی، جرقه و خرابی تجهیزات را افزایش دهد.

بهکارگیری تجهیزات پیشرفتهتر خنکسازی به کاهش نیاز به تعمیر و نگهداری منجر میشود که این امر نهتنها هزینههای عملیاتی را کاهش میدهد و احتمال بروز مشکلات حرارتی را کم میکند، بلکه با حذف ترددهای غیرضروری نیروهای فنی، ریسک ضربه، تماس ناخواسته و آسیب فیزیکی به تجهیزات را نیز کاهش میدهد.

علاوه بر این، سیستمهای پیشرفتهی سرمایش معمولاً سطح آلودگی صوتی (نویز) در محیط را کاهش میدهند. از آنجا که نویز نشانه ارتعاش اجزای مکانیکی است، وجود ارتعاش در محیط میتواند در بلندمدت تأثیر منفی بر عملکرد و پایداری تجهیزات فناوری اطلاعات داشته باشد[18].

چه استانداردهایی در حوزه آب و انرژی مراکز داده وجود دارد؟

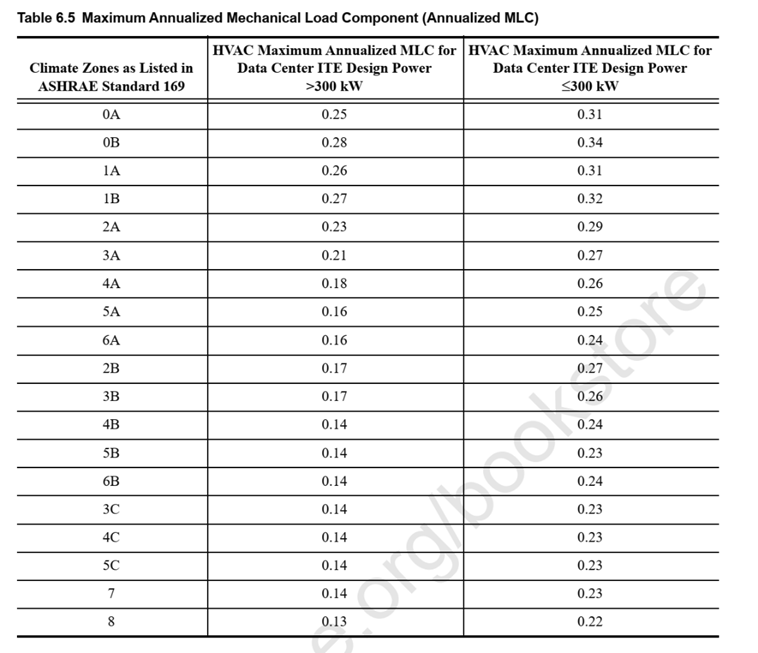

تنها استاندارد موجود برای بررسی عملکرد مراکز داده در حال کار و طراحی مراکز داده جدید در حال حاضر استاندارد اشری 4/90 است. این استاندارد با استفاده از شاخص بار مکانیکی و شاخص تلفات الکتریکی، حدود مجازی برای هریک از این دو کمیت ارائه میکند. شکل 5 از نسخه 2022 این استاندارد، حدود شاخص بار مکانیکی را برای اقلیمهای مختلف نشان میدهد. شاخص تلفات مکانیکی وابسته به اقلیم نیست و برای مراکز کوچکتر از 100 کیلووات در حالت عملکرد با ظرفیت کامل 142/0 و برای مراکز بزرگتر از آن 11/0 میباشد.

نسخه 2025 این استاندارد هماکنون منتشر شده اما مؤلف نتوانست نسخهای از آن به دست آورد. در توضیحات مربوط به نسخه جدید آمده است که دامنه کاربرد استاندارد در نسخه جدید به مسائل مربوط به انتشار کربن و کاهش میزان مصرف آب گسترش یافته است[19].

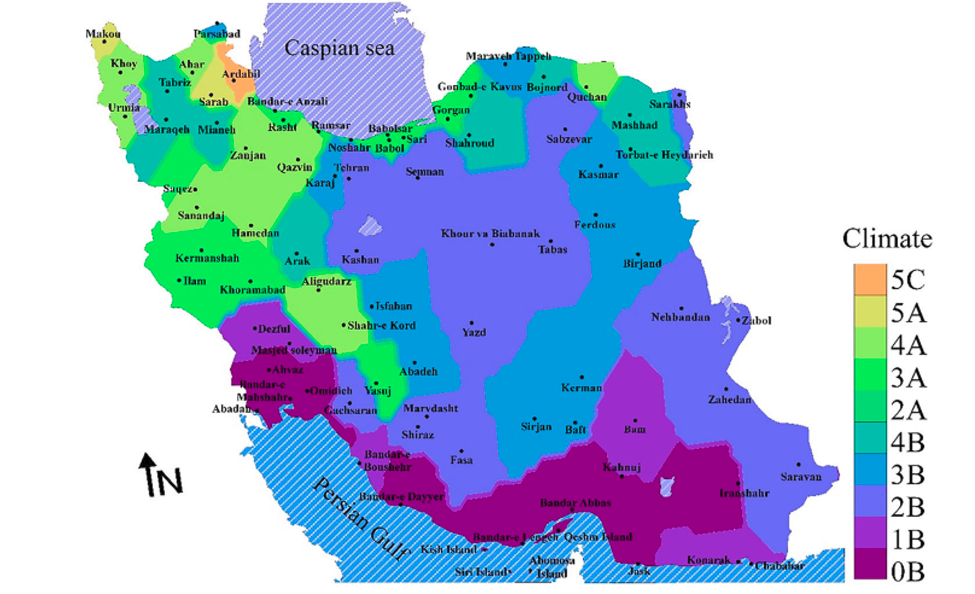

جهت استفاده از این استاندارد در ایران میبایست وضعیت آب و هوایی مناطق مختلف کشور طبق استاندارد اشری بررسی شود. اشراقی و همکاران [20] در سال 2021 با استفاده از دادههای آب و هوایی 82 مرکز هواشناسی سراسر کشور نقشه شکل 6 را تهیه کردهاند. در این سیستم طبقهبندی، شمارهها بیانگر منطقه دمایی از صفر (گرمترین) تا ۸ (سردترین) و حروف بیانگر منطقه رطوبتی به صورت A(مرطوب)، B(خشک) و C (ساحلی) وجود دارد است.

هرچه دمای محیط در طول سال سردتر باشد (شمارههای بزرگتر)، امکان استفاده از هوای بیرون در روش سرمایش طبیعی هواپایه بیشتر است که باعث کاهش مصرف انرژی تجهیزات خنککننده مکانیکی میباشد. همزمان، درصورتی که میزان رطوبت محیط بالا باشد (مانند منطقه ساحلی دریای خزر)، نیاز به رطوبتزدایی از فضای داخلی مرکز داده وجود خواهد داشت که مستلزم استفاده از تجهیزات انرژیبر است.

بهطور خلاصه، جانمایی مراکز داده در مناطق سردسیر (اعداد بزرگتر) و خشک (B) مانند مرکز استان خراسان رضوی (مشهد و تربت حیدریه)، غرب سمنان (شاهرود)، اراک، تبریز، میانه و مراغه (منطقه 4B) در شکل زیر پیشنهاد میشود.

مراکز داده در ایران چه وضعیتی دارند؟

طبق گزارش مرکز پژوهشهای مجلس، در سال 1397 تعداد 115 مرکز داده در سراسر کشور وجود داشته است. این گزارش برآورد میکند که در سال 1405 تعداد این مرکز به بیش از 300 واحد خواهد رسید. همچنین معاون تنظیمگری و توسعه سکوهای دیجیتال وزارت ارتباطات و فناوری اطلاعات در تاریخ 20 مهرماه 1404 خبر از بررسی وضعیت استانداردهای فنی و تخصصی 110 مرکز داده در سراسر کشور را داد[21]. شایان ذکر است که در این خبر بهطور صریح اشارهای نشده است که آیا میزان مصرف انرژی نیز در زمرهی شاخصهای مورد بررسی قرار گرفته است یا خیر.

جستوجوی نویسنده برای یافتن اطلاعات دقیق دربارهی روشهای خنککاری بهکاررفته در این مراکز نتیجهای در بر نداشت. با این حال، بر اساس بررسی تصاویر منتشرشده در اینترنت از این مراکز، میتوان حدس زد که اغلب مراکز داده در ایران از سامانههای خنککاری هواپایه بهره میبرند.

چه راهکارهایی برای کاهش مصرف آب و انرژی مراکز داده در ایران وجود دارد؟

بسته به نوع سیستم سرمایش مورد استفاده و وضعیت مرکز داده (در مرحله طراحی یا بهرهبرداری)، راهکارهای متفاوتی برای کاهش مصرف قابل بررسی است. با توجه به شواهد تصویری موجود، فرض میشود که اغلب مراکز داده فعال در حال حاضر از روشهای سرمایش هواپایه استفاده میکنند؛ ازاینرو، توضیحات ارائهشده در ادامه این پرسش، به این دسته از مراکز محدود میشود. بهطور کلی، راهکارهای کاهش مصرف را میتوان به دو دسته تقسیم کرد.

الف. غیرانرژیبر

مقصود از این نوع روشها آن است که با اعمال تغییرات اولیه، کاهش مصرف انرژی محقق میشود و در طول بهرهبرداری از تجهیزات، نیازی به صرف انرژی اضافی بهمنظور کاهش مصرف انرژی وجود ندارد.

ارتفاع کف و سقف: افزایش ارتفاع سقف موجب بهبود توزیع هوا و الگوی جریان آن در فضای مرکز داده شده و از شکلگیری نقاط گرم موضعی جلوگیری میکند. دو پژوهش مستقل نشان دادهاند که در صورت ورود هوا از کف تجهیزات، ارتفاع سقف حدود 5/2 متر ارتفاع بهینه است[22], [23]. بهطور کلی، با توجه به آنکه هوای گرم چگالی کمتری نسبت به هوای سرد دارد و به سمت بالا حرکت میکند، تأمین هوای سرد از کف و خروج آن از سقف باعث تبادل حرارت مؤثرتری فیمابین تجهیزات و سیال خنککننده (هوا) میشود.

در صورتی که کف مجموعه بالاتر از کف معماری قرار گیرد، فضای مناسبی برای عبور کابلها، سینیها و داکتهای توزیع هوا فراهم خواهد شد. همچنین به دلیل حرکت طبیعی هوای گرم به سمت بالا، ورود هوای سرد از پایین موجب کاهش افت فشار وارد بر فنهای سامانه تهویه مطبوع شده و در نتیجه مصرف انرژی فنها نیز کاهش مییابد. در مطالعات مختلف، بازهای در حدود ۶۰ تا ۹۶ سانتیمتر برای ارتفاع کف کاذب پیشنهاد شده است[24], [25].

در صورت استفاده از کف کاذب و ورود هوای سرد از زیر، لازم است هوا از طریق تایلهای منفذدار کف به فضای مرکز داده هدایت شود. پژوهشهای گستردهای درباره تعداد، اندازه و نحوه توزیع این منافذ بر روی تایلها انجام شده است[26]. هرچند تنوع تایلهای در دسترس ممکن است محدود باشد و انتخاب گزینه کاملاً بهینه امکانپذیر نباشد، اما ترکیب این موضوع با سایر ملاحظات معماری فضا میتواند نقش مؤثری در افزایش بهرهوری سیستم سرمایش مرکز داده ایفا کند.

با توجه به تفاوت در پلانهای معماری و تنوع تایلهای در دسترس در مراکز داده مختلف، پیشنهاد میشود با بهرهگیری از ابزارهای دینامیک سیالات محاسباتی (CFD)، بهترین ترکیب این دو عامل برای بهینهسازی توزیع و جریان هوا در فضای داخلی مرکز داده تعیین شود.

عایقبندی دیوار: افزایش سطح و کیفیت عایقها موجب کاهش تبادل حرارتی با محیط پیرامون شده و در نتیجه بار سرمایشی ساختمان را کاهش میدهد.

بام سفید: در صورتی که سقف مجموعه در مجاورت فضای آزاد قرار داشته باشد، ایزوگامکردن آن به دلیل رنگ تیره ایزوگام میتواند منجر به جذب حداکثری تابش خورشید و در نتیجه افزایش بار حرارتی ساختمان شود. در این شرایط، رنگآمیزی بام با رنگهای روشن (مانند سفید) یا استفاده از عایقهای با پوشش روشن میتواند نقش مؤثری در کاهش جذب حرارت ایفا کند. همچنین اجرای بام سبز، علاوه بر کاهش بار سرمایشی ساختمان، موجب بهبود جلوه بصری و ارتقای کیفیت هوای محیط پیرامون نیز خواهد شد[27], [28].

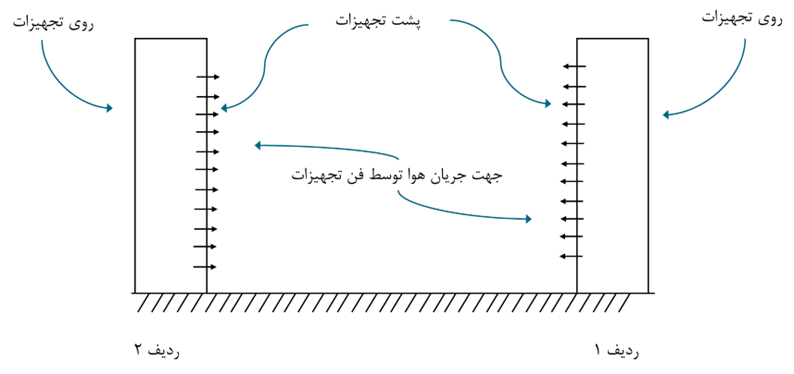

تغییر چینش تجهیزات: یکی از مهمترین روشهای کاهش مصرف انرژی در مراکز داده که پژوهشهای گستردهای نیز پیرامون آن انجام شده است، اصلاح نحوه چینش کابینتها (رکها) و تجهیزات داخل آنهاست[29]. در صورتی که تجهیزات در ردیفهای رک بهصورت پشتبهپشت نصب شوند (مطابق شکل 6 که نمای جانبی است) و این آرایش در سایر ردیفها نیز تکرار شود، فضاهای میانی بین رکها بهصورت یکدرمیان به نواحی گرم و سرد تقسیم خواهند شد.

در این حالت، بهعنوان مثال در شکل نشاندادهشده، فضای میانی گرمتر است زیرا فن تجهیزات در دو ردیف رک مجاور، گرمای تولیدشده ناشی از پردازش را به سمت این فضای مشترک هدایت میکنند. در مقابل، فضای سمت راست ردیف اول و سمت چپ ردیف دوم بهعنوان ناحیه سردتر عمل میکند. چنانچه ارتباط میان این فضاهای مشترک با مسدودسازی فضای بالای رکها و انتهای ردیفها مسدود شود و از اختلاط هوای گرم و سرد جلوگیری شود، بهرهوری سیستم سرمایش بهطور قابلتوجهی افزایش خواهد یافت[30].

در این آرایش، هوای سرد خروجی از سامانه تهویه باید به فضای میانی سردتر دمیده شود تا با مکش فن تجهیزات، از روی پردازندهها عبور کرده و تبادل حرارتی مؤثری با تجهیزات فناوری اطلاعات برقرار کند. هوای گرم خروجی نیز میبایست از بالای ناحیه گرمتر جمعآوری و خارج شود. در نهایت، فاصله بین ردیفهای رک، محل جانمایی دریچههای ورودی و خروجی هوا و سایر مشخصات هندسی از جمله پارامترهایی هستند که لازم است بهصورت بهینه طراحی و تنظیم شوند.

حذف فضای پرت: از جمله اقدامات ساده و کوتاهمدت برای کاهش مصرف انرژی، میتوان به مسدود کردن دریچههای هوای بخشهایی از مرکز داده که در حال حاضر مورد استفاده نیستند اشاره کرد. لازم به ذکر است که این اقدام باید همزمان با جداسازی فیزیکی فضای فعال و غیرفعال مرکز داده انجام شود؛ بهگونهای که موانع فیزیکی از پخش شدن هوا در کل فضای مرکز جلوگیری کنند. در غیر این صورت، مسدود کردن دریچهها نهتنها منجر به کاهش مصرف انرژی نخواهد شد، بلکه ممکن است یکنواختی دمای تجهیزات را مختل کرده و موجب ایجاد تنش حرارتی در آنها شود.

ب. انرژیبر

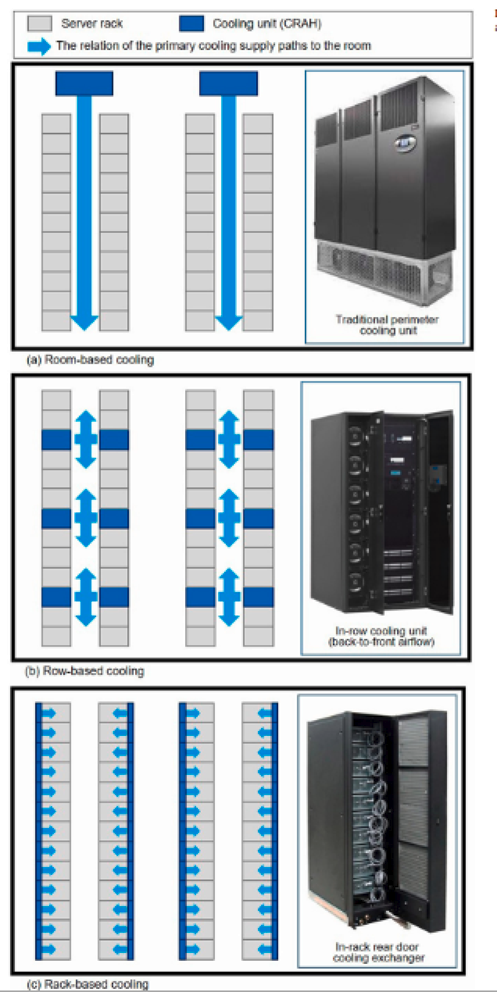

تغییر زونبندی سیستم سرمایش: در یک سیستم سرمایش، به بخشی از فضا که باید (در طراحی فرض میشود) دارای دمای یکنواخت است، «زون حرارتی» گفته میشود. نحوه تعریف این زونها تأثیر مستقیمی بر طراحی سیستم سرمایش داشته و بر میزان مصرف انرژی اثرگذار است. شکل 6 سه رویکرد متفاوت در این زمینه را نشان میدهد. در طرح نخست (بالا)، کل فضای اتاق بهعنوان یک زون حرارتی در نظر گرفته شده است. در طرح میانی، هر ردیف رک بهعنوان یک زون حرارتی مستقل تعریف میشود و در طرح پایینی، هر کابینت (رک) بهصورت مجزا یک زون حرارتی محسوب میگردد.

با افزایش تعداد زونهای حرارتی، تعداد فنها و تجهیزات جانبی مرتبط با سرمایش نیز افزایش مییابد؛ با این حال، امکان کنترل دقیقتر و مؤثرتر دمای تجهیزات فراهم میشود. به نظر نگارنده، افزایش تعداد زونها تنها برای تأسیسات زیرساختی بسیار حساس توجیهپذیر است و در اغلب کاربردهای غیرحساس، استفاده از یک زون حرارتی در مقیاس اتاق یا چند زون متناظر با ردیفهای رک، کفایت میکند.

سرمایش طبیعی: همانگونه که در توضیح انواع روشهای سرمایش اشاره شد، بهرهگیری از سرمایش طبیعی در شرایطی که دما و رطوبت هوای خارج از ساختمان در بازه قابل قبول قرار داشته باشد، یکی از سادهترین و در عین حال مؤثرترین راهکارهای کاهش مصرف انرژی بهشمار میرود. نتایج پژوهشها نشان میدهد که استفاده کنترلشده از هوای بیرون بسته به موقعیت جغرافیایی، اقلیم منطقه و نحوه بهرهبرداری از هوای تازه میتواند منجر به کاهش ۱۵ تا ۴۲ درصدی در هزینههای مرتبط با انرژی شود.

اکونومایز: در اینجا منظور از اکونومایزر، یک مبدل حرارتی واسط است که در مسیر بین برج خنککننده و چیلر نصب میشود و نقش آن بهرهگیری حداکثری از شرایط محیطی برای کاهش بار سرمایشی است. در زمانهایی که دمای هوای بیرون و دمای حبابتر[1] در محدوده مناسبی قرار داشته باشد، این مبدل امکان آن را فراهم میکند که چیلر بهطور کامل از مدار خارج شده و آب سرد مورد نیاز مدار سرمایش مستقیماً از طریق برج خنککننده تأمین شود.

حذف چیلر از مدار علاوه بر کاهش چشمگیر مصرف انرژی الکتریکی، موجب کاهش ساعات کارکرد چیلر و در نتیجه کاهش استهلاک، افزایش عمر مفید و کاهش هزینههای تعمیر و نگهداری این تجهیز گرانقیمت میشود. این موضوع بهویژه در مراکز دادهای که بهصورت ۲۴ ساعته در حال بهرهبرداری هستند، اهمیت دوچندانی پیدا میکند.

لازم به ذکر است که استفاده از اکونومایزر تنها در سیستمهایی امکانپذیر است که از چیلرهای آبخنک بهره میبرند، چرا که وجود برج خنککننده بخش جداییناپذیر این سامانههاست. در مقابل، در چیلرهای هواخنک به دلیل ماهیت عملکرد و نبود مدار آب برج خنککننده، امکان استفاده از این نوع اکونومایزر وجود ندارد.

ج. بازیافت و توزیع گرما

با توجه به آنکه مراکز داده در تمام طول سال نیازمند سرمایش هستند و بار مصرف تجهیزات فناوری اطلاعات آنها عموماً مستقل از ساعت شبانهروز و نسبتاً ثابت است، امکان بهرهبرداری از گرمای تولیدشده توسط این تجهیزات بهعنوان منبعی پایدار برای گرمایش فضاهای اطراف فراهم میشود. در سادهترین حالت، هوای گرم خروجی از فضای داخلی مرکز داده میتواند برای گرمایش فضاهای اداری یا سایر فضاهای مجاور در همان ساختمان مورد استفاده قرار گیرد.

در مقیاسهای بزرگتر، این گرما قابلیت آن را دارد که برای تأمین گرمایش ساختمانهای مجاور نیز بهکار گرفته شود؛ بهگونهای که این ساختمانها بهجای سرمایهگذاری برای نصب و بهرهبرداری از سامانههای گرمایشی مستقل، مستقیماً هوای گرم یا آب گرم تولیدشده در مرکز داده را دریافت کنند. در این رویکرد، همزمان با خنکسازی تجهیزات فناوری اطلاعات، از مصرف انرژی اضافی برای گرمایش ساختمانهای پیرامونی نیز جلوگیری میشود و بازده کلی سیستم انرژی بهطور محسوسی افزایش مییابد.

در سالهای اخیر، تحقیقات و پروژههای متعددی، بهویژه در کشورهای اروپایی، در زمینه بازیافت و استفاده مجدد از گرمای مراکز داده در حال انجام است و هماکنون طرحهای پژوهشی گوناگونی در سطح اتحادیه اروپا با هدف توسعه، بهینهسازی و گسترش این فناوری در دست اجرا قرار دارد[31].

د. تولید انرژی در محل

همانگونه که پیشتر اشاره شد، مراکز داده عموماً دارای بار سرمایشی تقریباً ثابتی در طول سال هستند. این ویژگی موجب میشود که در صورت بهکارگیری سامانههای تولید پراکنده، اعم از تولید صرف توان الکتریکی مانند دیزلژنراتورها، یا سامانههای تولید همزمان توان، گرمایش و سرمایش (CCHP)، این تجهیزات بتوانند بهطور پیوسته در نقطه بهینه عملکردی خود فعالیت کنند. در نتیجه، بازده کلی سیستم افزایش یافته و هزینههای بهرهبرداری کاهش مییابد.

افزون بر این، نصب منابع تجدیدپذیر نظیر پنلهای خورشیدی و توربینهای بادی میتواند نقش مؤثری در کاهش بار تحمیلی مراکز داده بر شبکه سراسری برق ایفا کند و تابآوری تأمین انرژی را افزایش دهد. در دولت جدید ایالاتمتحده، انرژی هستهای نیز بهعنوان یکی از گزینههای بالقوه برای تأمین انرژی مراکز داده مبتنی بر هوش مصنوعی با توان مصرفی بسیار بالا مطرح شده است؛ هرچند تا زمان نگارش این گزارش، این رویکرد هنوز به مرحله اجرا و بهرهبرداری عملی نرسیده است.[32]

ظرفیتهای قانونی این فناوری در ایران چیست؟

طبق اطلاعات به دست آمده اسناد مربوط به مراکز داده عموماً بر بعد فنی و تخصصی عملکرد اینگونه مجموعهها تأکید دارند و تاکنون توجه لازم به استانداردسازی میزان مصرف انرژی اینگونه مراکز صورت نگرفته است.

از جمله اسناد بالادستی موجود در ارتباط با مراکز داده میتوان به طرح کلان و معماری شبکه ملی اطلاعات برای افق 1404، سند راهبردی توسعه رایانش ابری جمهوری اسلامی، سند الزامات طراحی و توسعه زیرساختهای شبکه ملی اطلاعات، سند الزامات طراحی و توسعه قطب مراکز داده و سند اصول حاکم بر خدمات مراکز داده و خدمات ابری اشاره کرد.

نتیجهگیری و پیشنهادهای عملیاتی خانه همافزایی:

- پیشنهاد میشود با توجه به نبود استاندارد مصرف انرژی در کشور برای مراکز داده، در کوتاهمدت از استاندارد اشری 4/90 استفاده شود و در بلندمدت نسبت به تدوین استاندارد الزامی برای تعیین مقادیر حداکثر شاخص بار مکانیکی و تلفات الکتریکی اقدام شود.

- با توجه به شرایط اقلیمی کشور، زیرساختهای موجود فیبر نوری و الزامات اسناد بالادستی برای توسعه مراکز داده در استانها، پیشنهاد میشود احداث مراکز داده در مناطق مستعد استانهای خراسان رضوی، آذربایجان شرقی و غربی و اراک در اولویت قرار گیرد. همچنین بهمنظور تمرکززدایی از کلانشهرها، کاهش اثرات آلودگی هوابر تجهیزات و کاهش هزینههای خنککاری، جانمایی این مراکز در خارج از شهرهای بزرگ و در مجاورت خطوط فیبر نوری توصیه میشود که میتواند به ایجاد اشتغال در شهرهای کوچکتر نیز کمک کند.

مراجع:

[1] J. H. Raza Muhammad, “Data Centers Explained: Types, Features, and Choosing the Right Model,” Splunk. Accessed: Dec. 28, 2025. [Online]. Available: https://www.splunk.com/en_us/blog/learn/data-centers.html

[2] M. Wilson, “Data Center Basics,” Nlyte. Accessed: Dec. 28, 2025. [Online]. Available: https://www.nlyte.com/blog/data-center-basics/

[3] “Tier Classification System,” Uptime Institute. Accessed: Dec. 28, 2025. [Online]. Available: https://uptimeinstitute.com/tiers

[4] J. Huang, C. Chen, G. Guo, Z. Zhang, and Z. Li, “A calculation model for typical data center cooling system,” in Journal of Physics: Conference Series, IOP Publishing, 2019, p. 012022. [Online]. Available: https://iopscience.iop.org/article/10.1088/1742-6596/1304/1/012022/meta

[5] D. W. Demetriou, “The ASHRAE Thermal Guidelines for Data Centers Past, Present, and Future,” 2025.

[6] “ASHRAE_Contamination_Whitepaper_30_July_2009.pdf (SECURED).” Accessed: Dec. 29, 2025. [Online]. Available: https://datacenters.lbl.gov/sites/default/files/ASHRAE_Contamination_Whitepaper_30_July_2009.pdf?utm_source=chatgpt.com

[7] “ISO_IEC 30134-1(2016).pdf.” Accessed: Dec. 29, 2025. [Online]. Available: https://docbox.etsi.org/stf/Archive/STF516_M462_EnergyEfficiency/STFworkarea/WG1/Documents/Foundation/ISO_IEC%2030134-1(2016).pdf

[8] “ANSI ASHRAE Standard 90.4-2022 | PDF | Data Center,” Scribd. Accessed: Dec. 29, 2025. [Online]. Available: https://www.scribd.com/document/728742741/ANSI-ASHRAE-Standard-90-4-2022

[9] “Power usage effectiveness,” Google Data Centers. Accessed: Dec. 30, 2025. [Online]. Available: https://datacenters.google/efficiency

[10] “AWS Cloud – Amazon Sustainability.” Accessed: Dec. 30, 2025. [Online]. Available: https://sustainability.aboutamazon.com/products-services/aws-cloud

[11] “Measuring energy and water efficiency for Microsoft Datacenters,” Microsoft Datacenters. Accessed: Dec. 30, 2025. [Online]. Available: https://datacenters.microsoft.com/sustainability/efficiency/

[12] “Meta_2025-Environmental-Data-Index.pdf.” Accessed: Dec. 30, 2025. [Online]. Available: https://sustainability.atmeta.com/wp-content/uploads/2025/10/Meta_2025-Environmental-Data-Index.pdf

[13] U. N. Environment, “Sustainable Procurement Guidelines for Data Centres and Servers | UNEP – UN Environment Programme.” Accessed: Dec. 29, 2025. [Online]. Available: https://www.unep.org/resources/toolkits-manuals-and-guides/sustainable-procurement-guidelines-data-centres-and-servers

[14] S. Wiriyasart and P. Naphon, “Liquid impingement cooling of cold plate heat sink with different fin configurations: High heat flux applications,” Int. J. Heat Mass Transf., vol. 140, pp. 281–292, 2019.

[15] “Data Center Cooling: Air vs. Liquid – Which Way to the Future? | LG Global Business,” LG Global. Accessed: Dec. 28, 2025. [Online]. Available: https://www.lg.com/global/business/insights/hvac/blog/data-center-cooling-air-vs-liquid-which-way-to-the-future/

[16] A. Shehabi et al., “United States Data Center Energy Usage Report,” LBNL–1005775, 1372902, June 2016. doi: 10.2172/1372902.

[17] N. Lei, J. Lu, A. Shehabi, and E. Masanet, “The water use of data center workloads: A review and assessment of key determinants,” Resour. Conserv. Recycl., vol. 219, p. 108310, 2025.

[18] K. Mori, C. Taylor, J. Steinbuck, and D. Bohan, “Demonstration of Low-Cost Data Center Liquid Cooling,” California Energy Comission, Energy Research and Development (500), California, USA, CEC-500-2024-061, June 2024.

[19] “ASHRAE 90.4-2025 | ASHRAE Store.” Accessed: Dec. 29, 2025. [Online]. Available: https://store.accuristech.com/standards/ashrae-90-4-2025?product_id=3032033

[20] H. Eshraghi, M. Ansari, S. Moshari, and J. Gholami, “Climatic zoning and per capita demand forecast of Iran using degree-day method,” Adv. Build. Energy Res., vol. 15, no. 6, pp. 683–708, Nov. 2021, doi: 10.1080/17512549.2019.1654918.

[21] “ارزیابی ۱۱۰ مرکز داده؛ تا ۲ ماه آینده مراکز به ابردولت منتقل میشوند – خبرگزاری مهر | اخبار ایران و جهان | Mehr News Agency.” Accessed: Dec. 29, 2025. [Online]. Available: https://www.mehrnews.com/news/6612934/%D8%A7%D8%B1%D8%B2%DB%8C%D8%A7%D8%A8%DB%8C-%DB%B1%DB%B1%DB%B0-%D9%85%D8%B1%DA%A9%D8%B2-%D8%AF%D8%A7%D8%AF%D9%87-%D8%AA%D8%A7-%DB%B2%D9%85%D8%A7%D9%87-%D8%A2%DB%8C%D9%86%D8%AF%D9%87-%D9%85%D8%B1%D8%A7%DA%A9%D8%B2-%D8%A8%D9%87-%D8%A7%D8%A8%D8%B1%D8%AF%D9%88%D9%84%D8%AA-%D9%85%D9%86%D8%AA%D9%82%D9%84-%D9%85%DB%8C-%D8%B4%D9%88%D9%86%D8%AF

[22] S. Bhopte, D. Agonafer, R. Schmidt, and B. Sammakia, “Optimization of data center room layout to minimize rack inlet air temperature,” 2006, Accessed: Dec. 31, 2025. [Online]. Available: https://asmedigitalcollection.asme.org/electronicpackaging/article-abstract/128/4/380/477584

[23] S. Nagarathinam, B. Fakhim, M. Behnia, and S. Armfield, “A Comparison of Parametric and Multivariable Optimization Techniques in a Raised-Floor Data Center,” J Electron Packag, July 2013, doi: https://doi.org/10.1115/1.4023214.

[24] S. A. Nada and M. A. Said, “Comprehensive study on the effects of plenum depths on air flow and thermal managements in data centers,” Int. J. Therm. Sci., vol. 122, pp. 302–312, 2017.

[25] A. H. Beitelmal, “Numerical Investigation of Data Center Raised-Floor Plenum,” presented at the ASME 2015 International Mechanical Engineering Congress and Exposition, Texax, USA: ASME, Mar. 2016. doi: https://doi.org/10.1115/IMECE2015-50884.

[26] S. Cai and Z. Gou, “Towards energy-efficient data centers: A comprehensive review of passive and active cooling strategies,” Energy Built Environ., 2024, Accessed: Dec. 31, 2025. [Online]. Available: https://www.sciencedirect.com/science/article/pii/S2666123324000916

[27] I. Andric, A. Kamal, and S. G. Al-Ghamdi, “Efficiency of green roofs and green walls as climate change mitigation measures in extremely hot and dry climate: Case study of Qatar,” Energy Rep., vol. 6, pp. 2476–2489, 2020.

[28] F. Ascione, “Energy conservation and renewable technologies for buildings to face the impact of the climate change and minimize the use of cooling,” Sol. Energy, vol. 154, pp. 34–100, 2017.

[29] H. Rong, H. Zhang, S. Xiao, C. Li, and C. Hu, “Optimizing energy consumption for data centers,” Renew. Sustain. Energy Rev., vol. 58, pp. 674–691, 2016.

[30] A. A. Alkrush, M. S. Salem, O. Abdelrehim, and A. A. Hegazi, “Data centers cooling: A critical review of techniques, challenges, and energy saving solutions,” Int. J. Refrig., vol. 160, pp. 246–262, 2024.

[31] X. Yuan et al., “Data center waste heat for district heating networks: A review,” Renew. Sustain. Energy Rev., vol. 219, p. 115863, 2025.

[32] “Advantages and Challenges of Nuclear-Powered Data Centers,” Energy.gov. Accessed: Dec. 31, 2025. [Online]. Available: https://www.energy.gov/ne/articles/advantages-and-challenges-nuclear-powered-data-centers